阿里通义千问 Qwen3 开源全新推理模型!

阿里通义千问Qwen3-30B-A3B-Thinking-2507开源:256K上下文推理怪兽

在数学与代码领域全面碾压Gemini2.5-Flash,原生256K上下文可扩展至1M,轻量体积本地部署零门槛,开源社区即刻体验。

三个月磨一剑,Qwen3-30B-A3B-Thinking-2507强势登场

距离4月29日开源的Qwen3-30-A3B仅过去三个月,阿里通义千问团队再次放大招。今日,官方公众号低调宣布推出全新推理模型Qwen3-30B-A3B-Thinking-2507,用“再进化”来形容都显得保守。它不仅在数学与代码两项硬核指标上双双刷新开源天花板,还把上下文长度一口气拉到1M tokens,堪称“小而美”的推理怪兽。

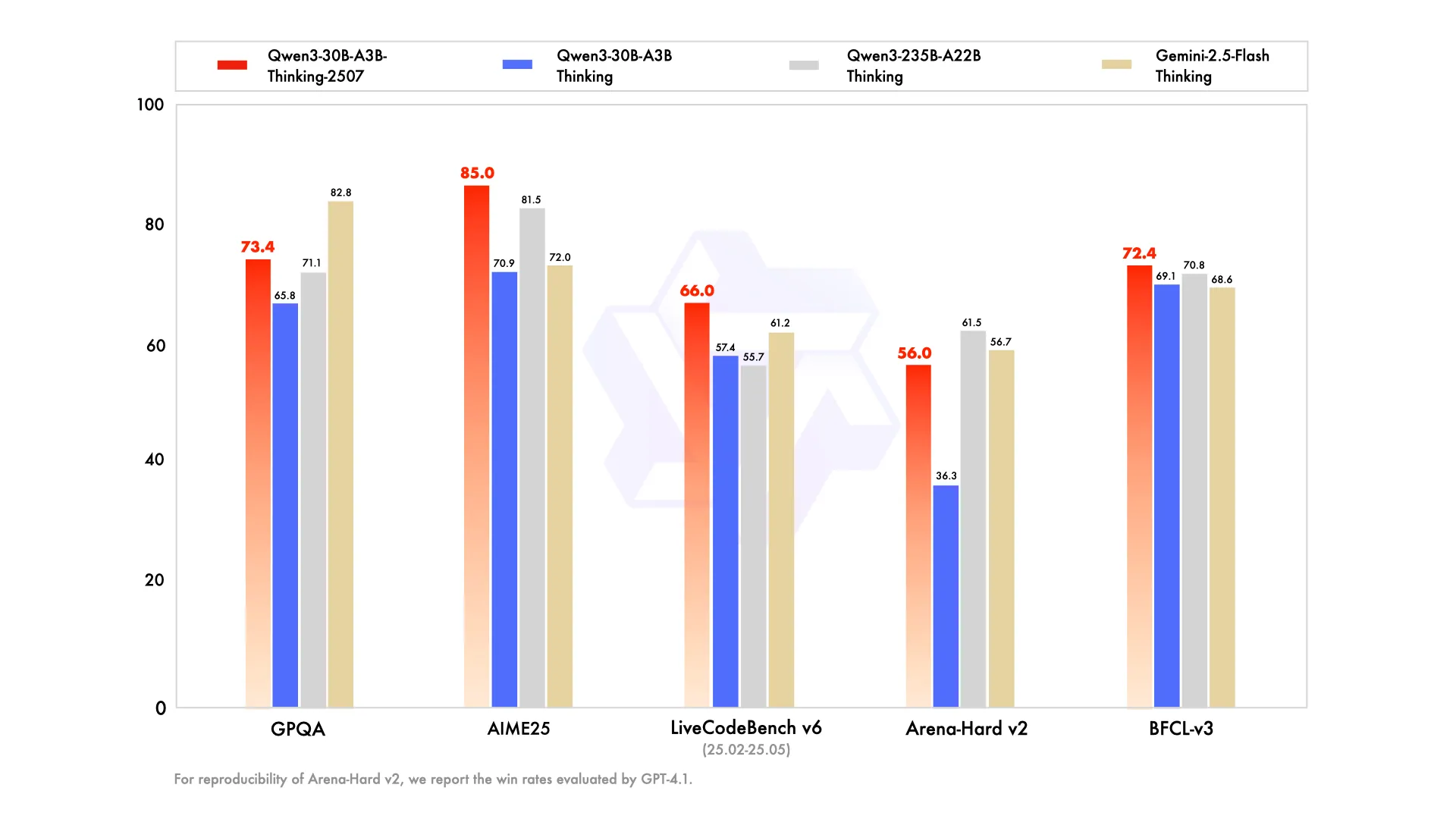

数学85分、代码66分,硬核成绩一览

- AIME25数学评测:85.0分

直接超越Gemini2.5-Flash(thinking)与自家大哥Qwen3-235B-A22B(thinking),在奥数级难题面前依旧稳如老狗。 - LiveCodeBench v6代码评测:66.0分

在真实编程场景里,模型不仅写得出,还能跑得通,Debug能力肉眼可见地提升。 - GPQA、MMLU-Pro知识基准

通用知识水平较上一代显著跃升,真正做到“既专又博”。

256K→1M tokens,长文本理解一步到位

过去,30B级别模型常被吐槽“记不住前文”。Qwen3-30B-A3B-Thinking-2507原生支持256K tokens,借助稀疏注意力机制可扩展至1M tokens,一口气读完一本《三体》三部曲毫无压力。官方建议:面对复杂推理任务时,把思考预算(thinking budget)调高,模型会像资深顾问一样层层推演,给出滴水不漏的结论。

通用能力全面开花,写作Agent多轮对话全拿捏

除了硬核推理,新模型在“软实力”上也毫不含糊:

- WritingBench写作评测:长文结构、文采与逻辑并重,写论文、写脚本、写小红书文案统统拿下。

- BFCL-v3 Agent能力:函数调用、工具使用一气呵成,开发者可以把复杂任务放心交给它。

- MultiIF多语言指令遵循:中英日韩法德西,一句话切换,跨语种场景零门槛。

消费级显卡即可本地部署,魔搭与HuggingFace同步开源

体积依旧轻盈,单张RTX 4090即可流畅推理。魔搭社区与HuggingFace已同步放出权重,开发者只需两行命令即可把这位“推理怪兽”请回家。想先尝后买?官方在线体验地址也已上线,打开浏览器就能开聊。

官网在线体验地址:https://chat.qwen.ai/

评论 (0)